Nous vous partageons aujourd’hui le bilan d’un projet que nous avons mené en 2023 et 2024 pour soutenir la Maison des Femmes de Grenoble sur des questions de cyberviolences.

La Maison des Femmes de Grenoble

Portée par l’association Uni·esverselles, la maison des femmes Grenoble Alpes, inaugurée en 2022, est un espace d’accueil et de soin destiné à accompagner les femmes confrontées à des violences et aux conséquences sur leur santé. Elle accueille une équipe pluri-disciplinaire composée de professionnel·le·s de santé à même d’accompagner au mieux les personnes reçues sur du court, moyen et long terme.

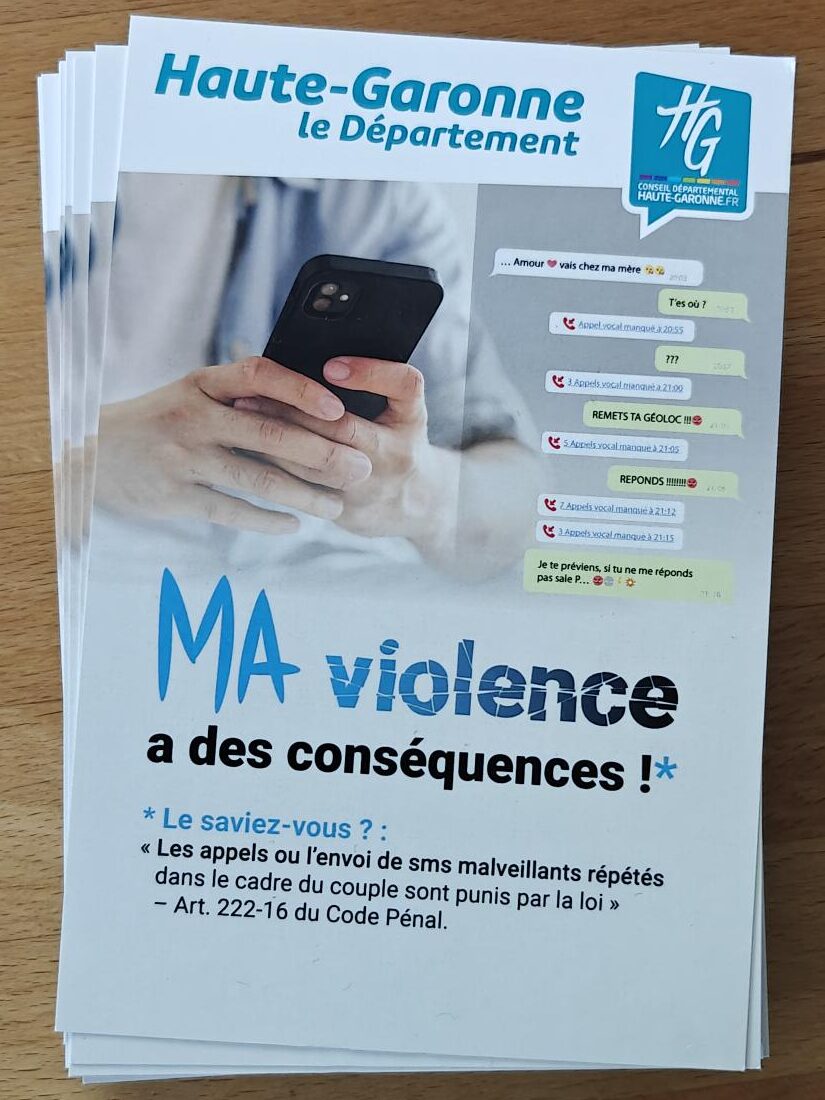

Au sein de cette activité, les professionnel·le·s de la maison des femmes rencontrent régulièrement des situations en rapport avec les cyberviolences sous la forme de harcèlement ou de différents types de surveillance par un conjoint abusif. Cette problématique est un enjeu primordial, notamment pour pouvoir :

- mieux accompagner les personnes victimes de violences reçues par la structure,

- éviter que cette cyber-surveillance ne les mette en danger dans leur parcours de soin,

- protéger les professionel·le·s de santé et la maison des femmes d’éventuelles représailles.

La proposition d’Echap

En décembre 2022, l’association Uni·esverselles a contacté Echap pour être accompagnée dans un projet global concernant les cyberviolences. Quelques mois plus tard et après avoir discuté des besoins détaillés de la structure, nous tombons d’accord sur une proposition qui se décline en trois parties :

- Créer un atelier sur les cyberviolences à destination des usagères de la structure.

- Faire une formation pour le personnel de la Maison des Femmes.

- Améliorer la procédure d’accueil des usagères pour prendre en compte les cyberviolences.

Atelier

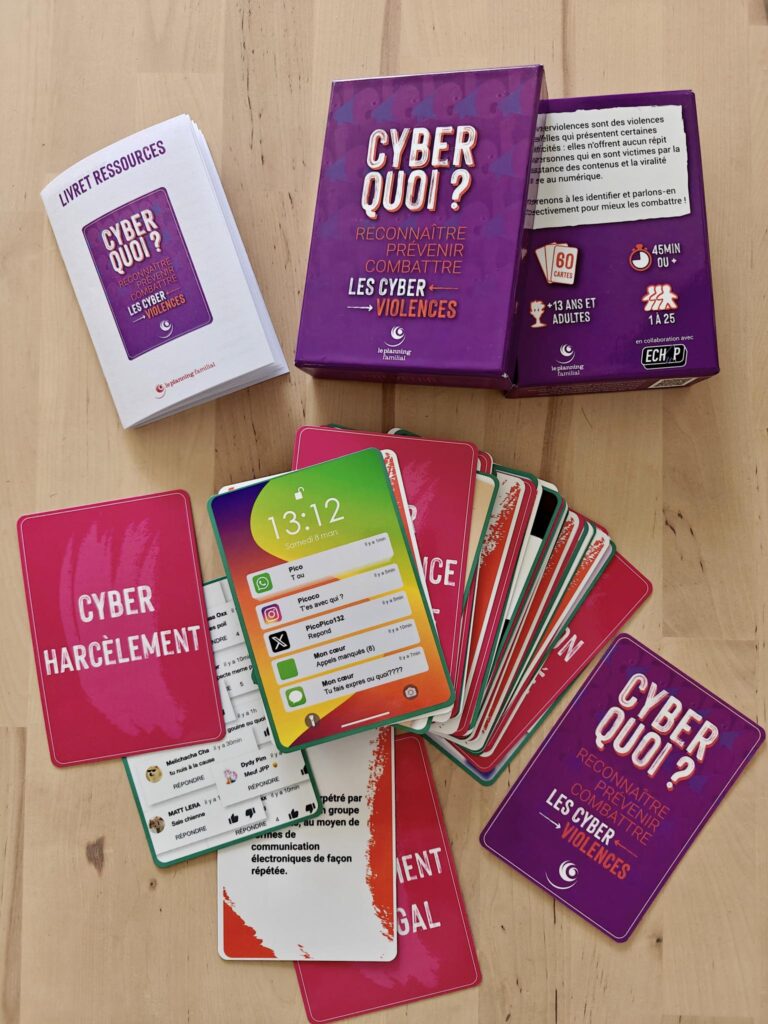

La première partie consiste à créer ensemble un atelier qui sera donné par le personnel de la Maison des Femmes à destination de leurs usagères pour sensibiliser à la question des cyberviolences.

Tout d’abord, nous définissons les critères et contraintes liées à la demande : par qui sera donné cet atelier, pour quel type de public, pour combien de personnes, quels en sont les objectifs… Tout ceci est le fruit de plusieurs réunions qui mènent à la conception d’un déroulé détaillé à destination du personnel de la structure, de diapositives, mais aussi de supports pour l’animation et d’une fiche de ressources pour les usagères.

Nous définissons donc les objectifs de cet atelier : appréhender des notions de base de soin numérique dans le cadre de cyberviolences et redonner autonomie et confiance dans les usages, outils et appareils utilisés à l’aide de stratégies adaptées. Il se destine à un public débutant sur la question du numérique et potentiellement victime de cyberviolences. Le nombre de personnes participantes conseillé est de 10 maximum pour une personne animatrice et l’atelier dure 3 heures.

Quatre parties composent cet atelier :

- Outils numériques : donner une vue d’ensemble de ce qui constitue le monde numérique et permet d’identifier les liens entre les différents outils en vue de sécuriser son environnement.

- Les cyberviolences : nommer les cyberviolences et comprendre dans quels cadres elles interviennent.

- Sécuriser ses comptes : avoir une approche pratique de sécurisation et mesurer l’ampleur de sa présence en ligne.

- Partage de stratégies : laisser l’espace libre pour que les participant·es puissent partager leur propres stratégies.

Formations

La seconde partie de ce projet se découpe en deux actes : une première introduction aux cyberviolences en ligne en juillet 2023 suivie d’une formation de deux jours sur place. L’objectif de la première session en ligne est de donner des bases de compréhension sur les cyberviolences à un maximum de professionnelles de la maison des femmes (la formation étant courte et en ligne, cela a donné suffisamment de flexibilité pour avoir le maximum de personnes présentes).

La formation en présentiel s’est déroulée en novembre 2023 à Grenoble et a permis de reposer les bases précédemment évoquées et d’approfondir des aspects techniques et pratiques afin de redonner confiance en ses propres savoirs dans l’accompagnement de victimes de cyberviolences. Cette formation a été un moment particulièrement fort : nous avions en face de nous des personnes ravies de se retrouver entre elles, puisqu’elles ne peuvent parfois que se croiser brièvement dans les locaux. Nous avons identifié ce besoin dès le début de ces deux jours comme étant essentiel et ainsi tenté de travailler sur la valorisation de cette dynamique collective.

Nous avons à cœur de proposer des temps théoriques et pratiques au sein de nos formation et d’essayer d’inclure des valeurs portées par le mouvement de l’éducation populaire. Malgré cela nous avons parfois une position ambivalente puisqu’il nous est aussi demandé de délivrer du contenu technique sur le numérique et nous sommes conscient·es du travail qu’il nous reste à effectuer pour éviter des postures d’expert·es sachant·es.

Procédure d’accueil des cyberviolences

La dernière partie de ce projet concerne l’écriture d’une procédure d’accompagnement incluant les risques de cyberviolences lors de l’accueil de nouvelles usagères. Nous avons donc tout d’abord discuté avec les professionnelles pour comprendre leurs problématiques et leur façon de travailler puis rédigé une proposition d’intégration de la question des cyberviolences dans leur processus de travail. Celle-ci implique notamment d’identifier les situations de cyberviolences le plus tôt possible via des questions lors des premiers entretiens, puis de les considérer au sein de leur parcours de soin et d’intégrer quand nécessaire des échanges et du soutien, voire des entretiens spécifiques.

Au cours de ce travail, la nécessité de soutien ponctuel provenant d’une personne extérieure à la Maison Des Femmes a été identifiée et nous avons aidé à définir les besoins liés à ce genre de recrutement. Ont aussi été évoquées les associations locales potentiellement aptes à accompagner la structure, mais aussi les aspects plus légaux (garder des preuves, liste de contacts sur le plan juridique…).

Enfin, cette procédure inclut également une liste de recommandations pour mieux protéger la structure et ses acteurices des cyberviolences.

Les principales difficultés

La Maison des Femmes de Grenoble est une structure récente qui fait face à des contraintes particulières : l’équipe pluridisciplinaire n’a aucun poste à « temps plein » sur une semaine complète puisque chaque personne travaille aussi en dehors de la structure, ce qui a pu régulièrement provoquer de gros décalages dans les plannings initiaux proposés et donc beaucoup de retard.

Nous attendions davantage de participantes pour l’introduction aux cyberviolences à distance, mais les plannings étaient visiblement complexes à gérer pour tout le monde.

Ce projet a été conséquent pour nous au sein d’Echap qui n’avions jamais eu de demande aussi globale de la part d’une structure travaillant dans le cadre des VSS.

Les points forts

L’élaboration de l’atelier a permis de mettre en commun des savoirs partagés reliés à l’éducation populaire et à l’animation et de voir que nous étions aligné·es sur les objectifs et le discours que nous portons.

Comme souligné précédemment, le temps de formation en présentiel a été fructueux et apprécié, cela nous a donné encore plus envie de continuer ce travail très gratifiant grâce à la réception de l’équipe étendue de la Maison des Femmes.

Enfin, cette collaboration a été une rencontre riche avec des personnes expertes, techniquement formées aux risques autour des Violences Sexistes et Sexuelles. Cela nous montre encore une fois à quel point le travail de terrain est probablement le plus apte à proposer un panel de stratégies efficaces pour lutter contre celles-ci. Cela nous a également permis de mieux comprendre la question des cyberviolences au sein des structures de santé.

Pour conclure ce bilan, nous souhaitons remercier une fois de plus la Maison Des Femmes pour la confiance et le travail apportés dans cet échange !